Cherry Studio 保姆级配置流程-适用所有手动配置参考

把 Gety 接入 Cherry Studio,让 AI 基于你的本地文件直接回答。

一、在 Gety 中启用 MCP

-

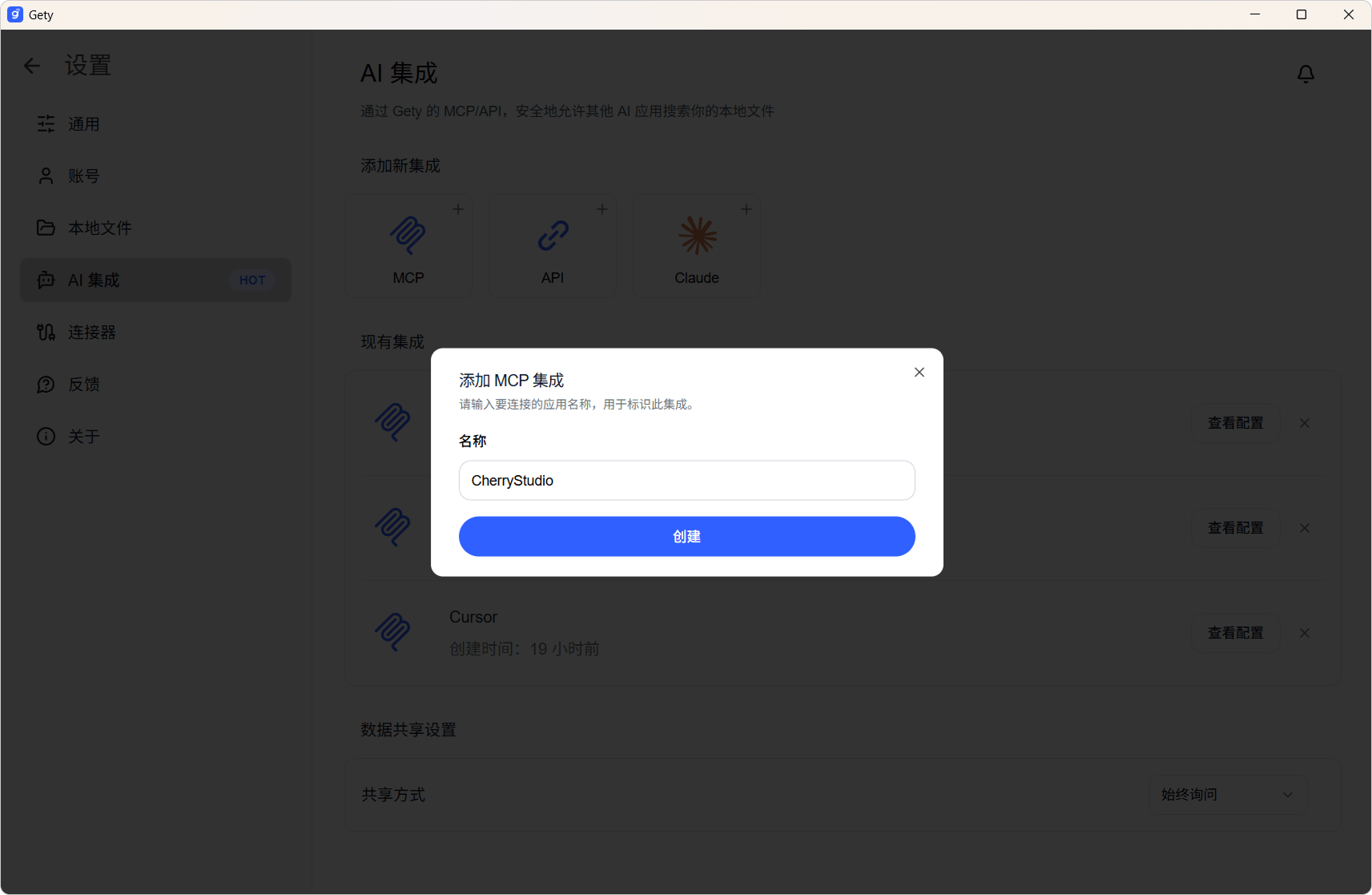

打开 Gety -> 设置 -> AI 集成,选择 MCP。

-

在弹窗中输入易记的名称(如 “CherryStudio” ),点击「创建」。

-

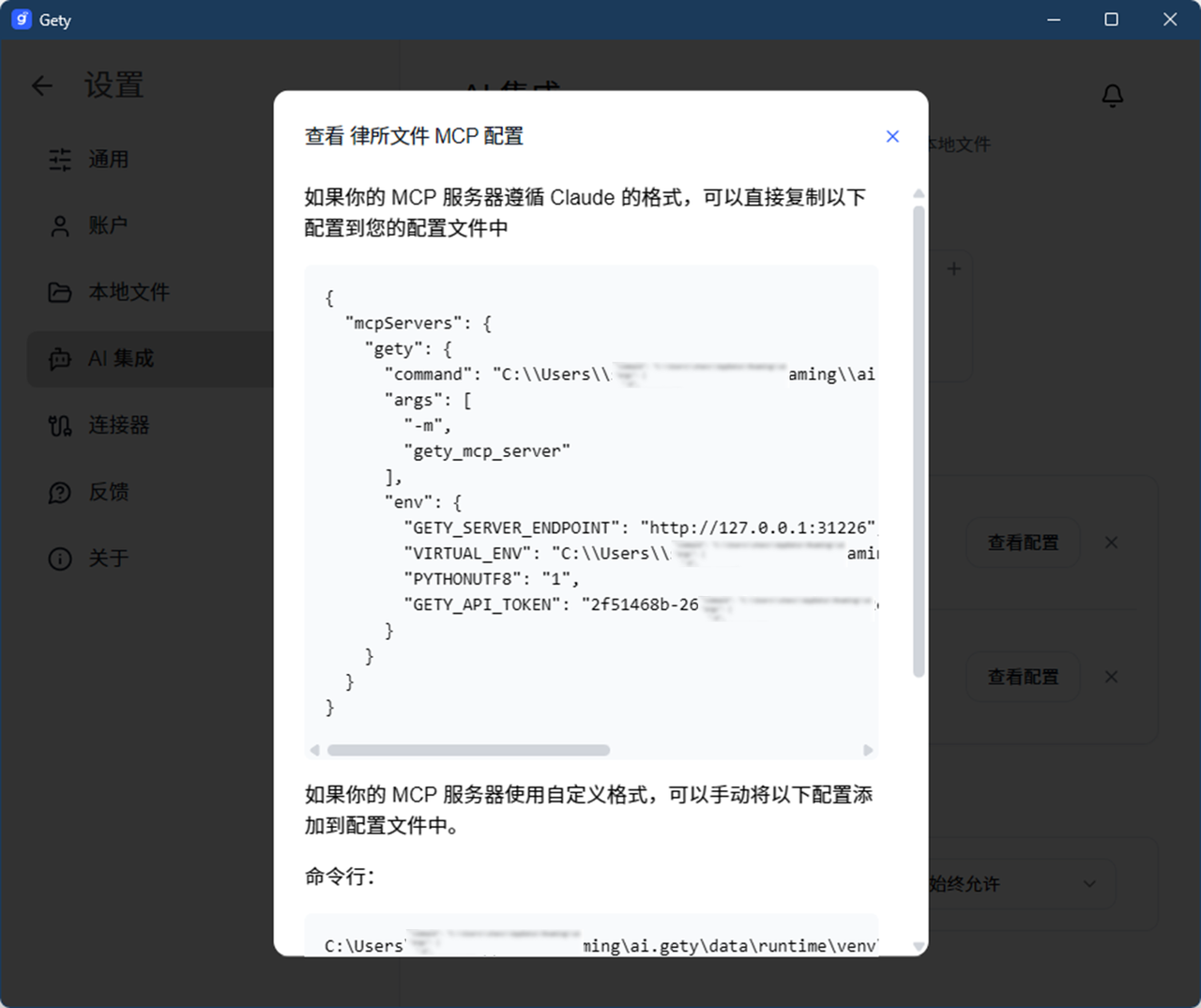

复制生成的 JSON 配置信息备用。

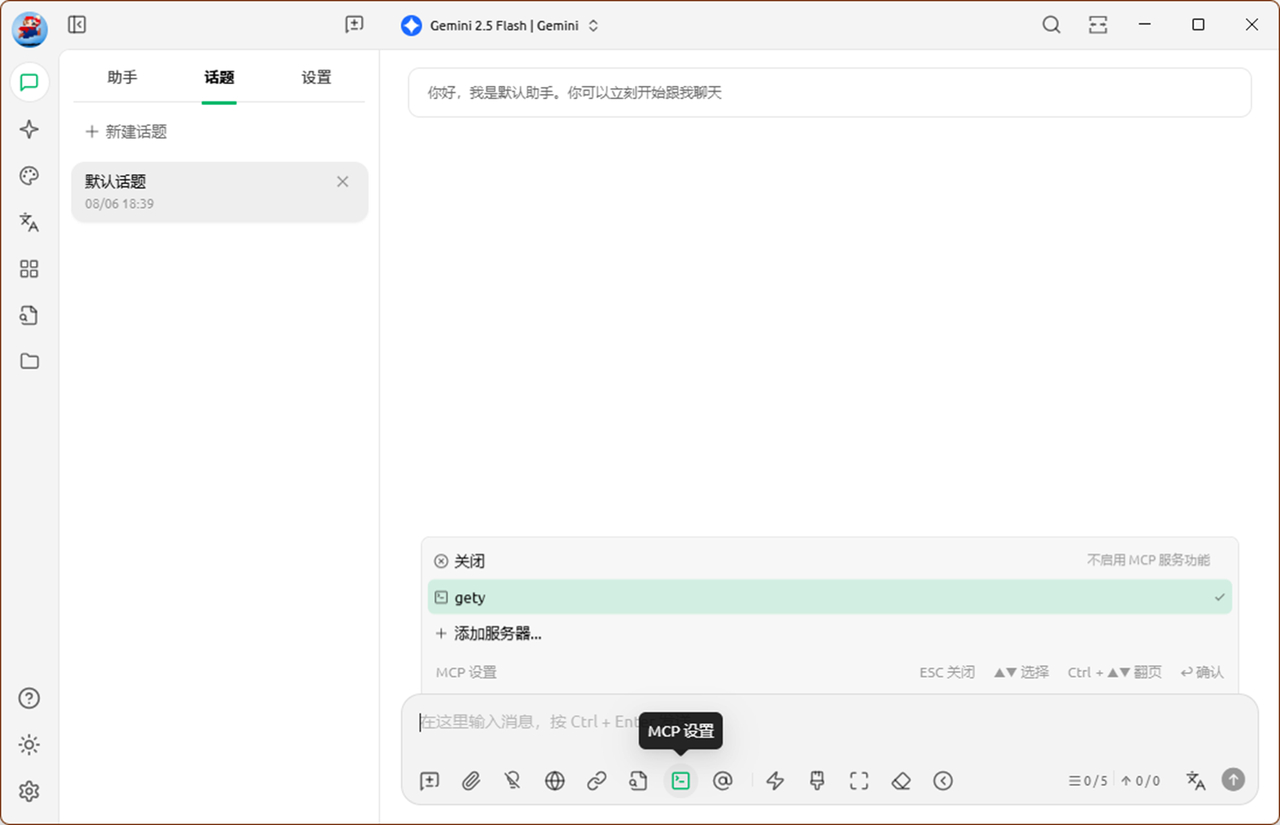

二、在 CherryStudio 中添加 Gety

-

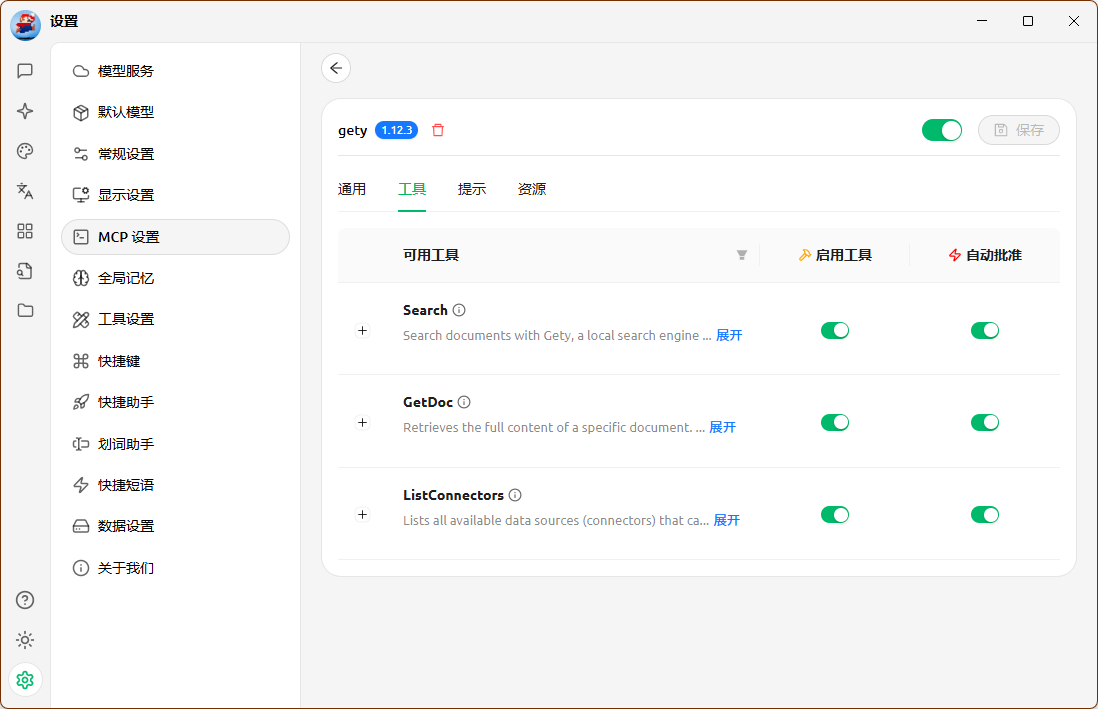

打开 设置 -> MCP 设置 -> 添加服务器 -> 从 JSON 导入

-

粘贴刚才复制的配置信息��,点击「确定」。

-

若在 Cherry Studio 中出现“启动失败”等错误提示,可能是 Gety 的 Python 运行环境没有设置完成。请耐心等待后重试。

-

在 工具 标签下确认 Gety MCP 是否显示 3 个可用工具。

三、添加 API Key(若已配置可跳过)

-

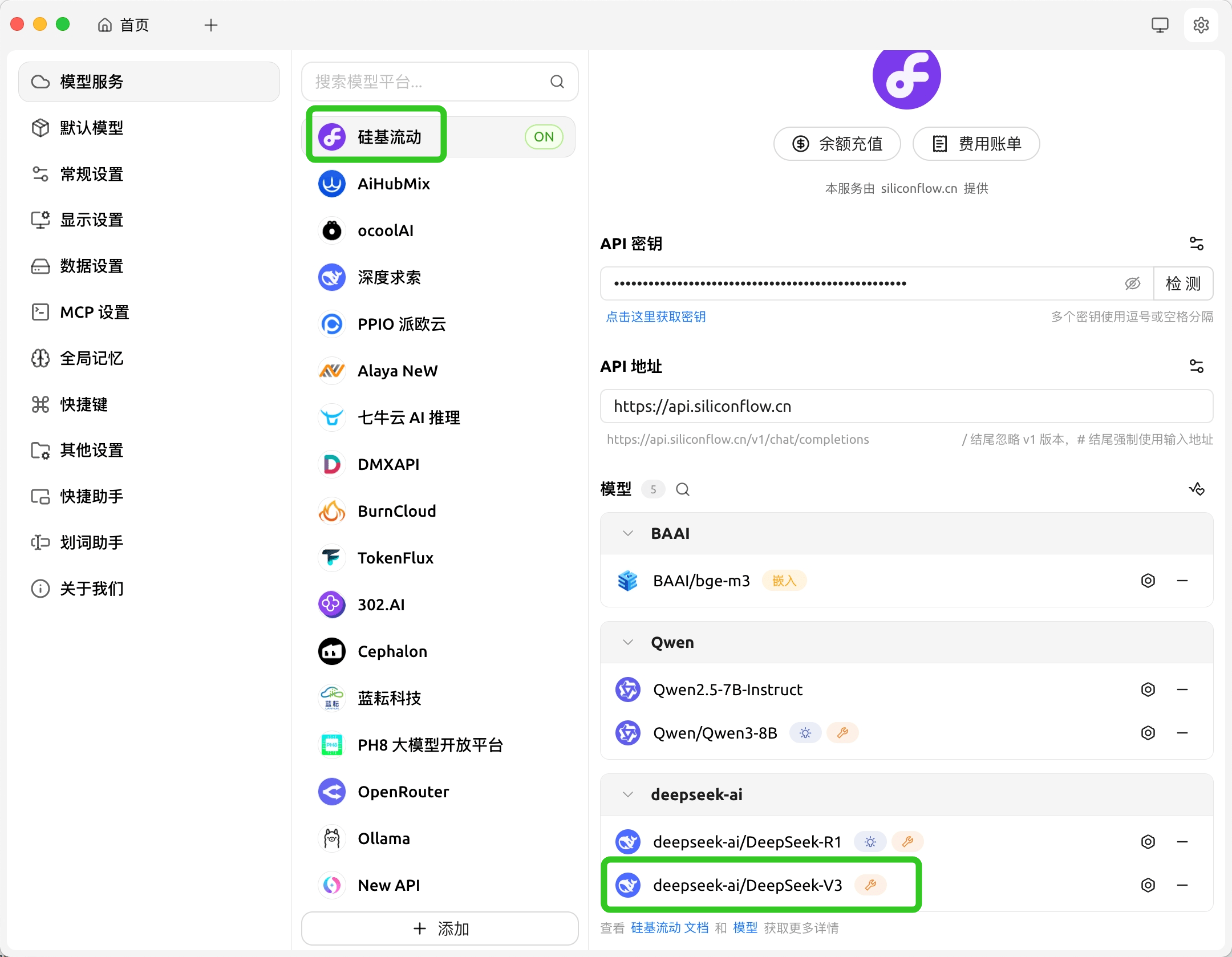

如果是第一次使用 Cherry Studio,推荐使用硅基流动 DeepSeek-V3 模型。可以注册硅基流动账号,免费使用。

-

你也可以选择任意大模型。为了更精准的回答,建议优先选择 参数量更高、更领先的大模型。

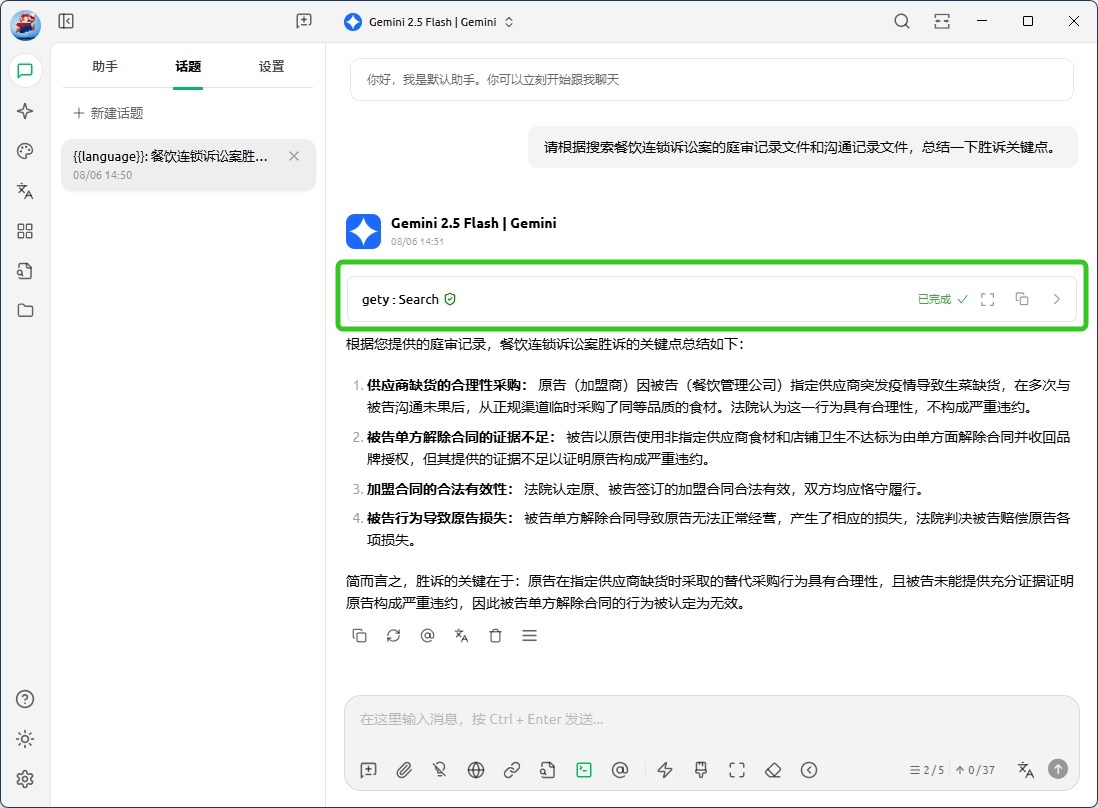

四、开始使用

-

开始使用前,请确认 Gety 在后台保持运行,否则无法正常调用。

-

在 Cherry Studio 的聊天输入框下方点击 MCP 图标,勾选 Gety,即可开始和 AI 对话。

-

现在,AI 就能直接引用你的本地文件回答问题。

示例:请使用 Gety 进行搜索。在我的服务合同里找出关于付款节点的条款,并引用原文。

-

⚠️ 注意:大模型可能生成虚构信息,让你误以为已经调用了 Gety。请始终确认 Gety 的 MCP 工具确实被调用。

五、使用提示

在使用 AI 调用时,请注意以下几点:

-

保持 Gety 在后台运行。 若已退出,AI 将无法调用 Gety。

-

要获得最佳的搜索与回答效果,建议先让 Gety 完成全部索引(包括语义索引)。在索引未完成时,你仍然可以正常使用,但结果可能不完整。

-

建议优先选择 参数量更高、更领先的大模型,以获得更深入、更精准的回答。

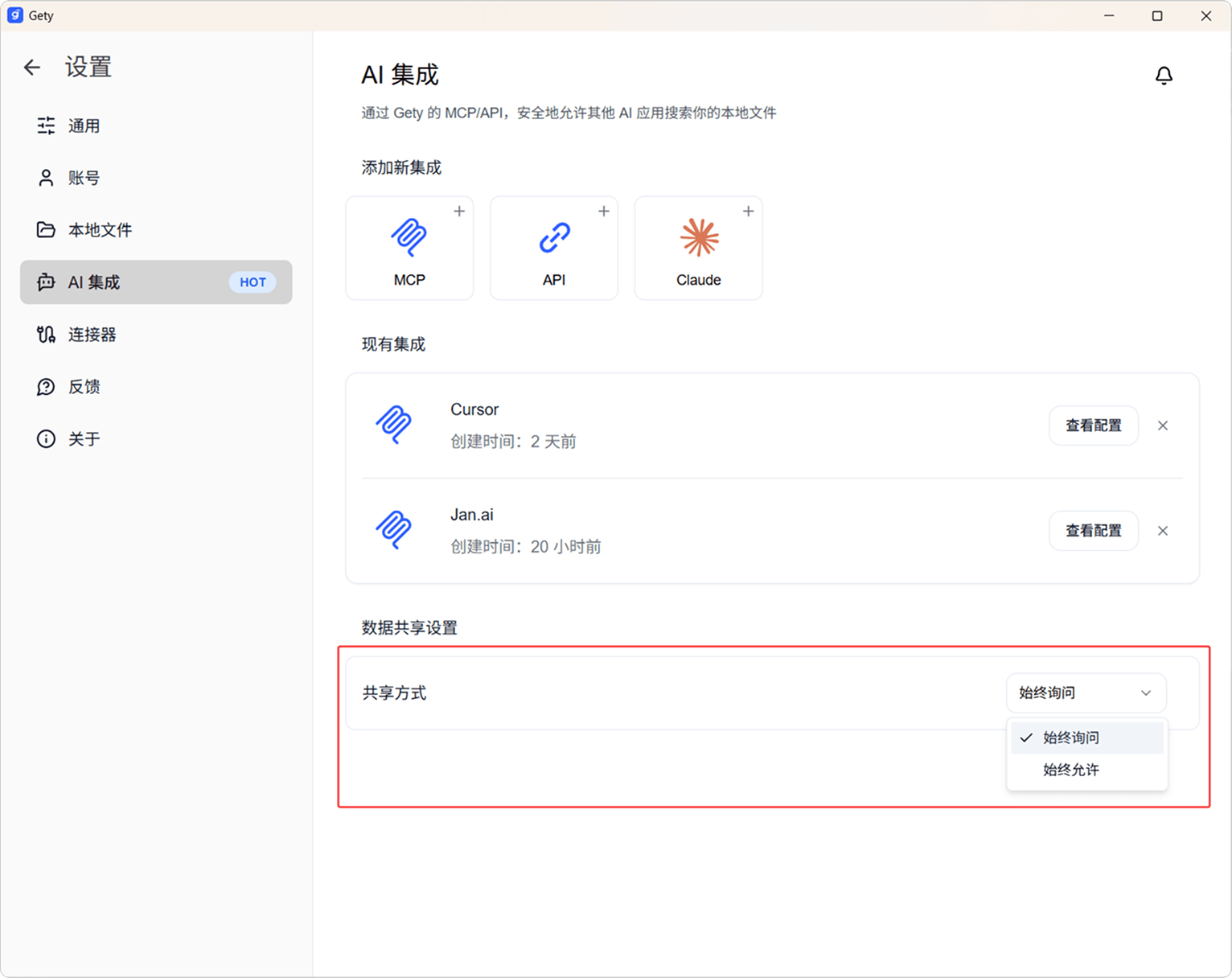

六、隐私保护

⚠️ 重要说明:Gety 本身是一款纯本地搜索工具,在 Gety 中进行的所有搜索都在本地离线完成的,不会上传到云端。

如果你希望 AI 能理解并回答与你的本地文件相关的问题,就需要用到 Gety �的 AI 集成功能。借助这一功能,AI 工具可以调用 Gety 的搜索结果,为你提供更贴合本地文件、更智能的回答。

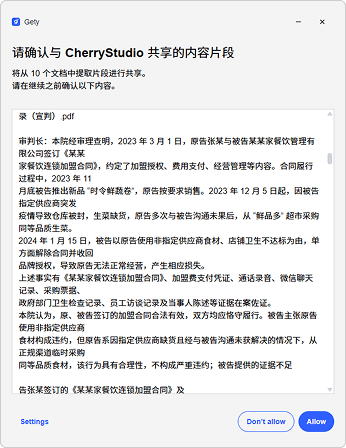

我们非常重视隐私,只与 AI 共享以下两类数据:

-

与搜索最相关的文档片段

-

当 AI 判定需要更完整的上下文时,片段所在的完整文档

你可以根据自己的隐私偏好选择数据共享方式:

-

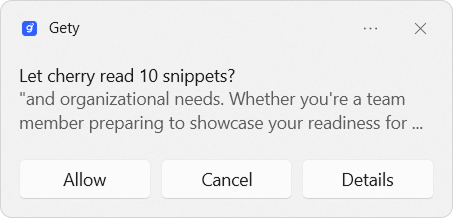

始终询问

-

每次需要发送内容前(无论是片段还是完整文档),都会弹出系统的确认通知。

在 Windows 中系统通知显示在右下角,在 macOS 中系统显示在右上角。请确保系统通知处于开启状态。

-

点击「 Details 」即可预览即将发送的本地内容,请确保不包含敏感信息。

-

如果内容涉及隐私,你可以选择拒绝,本次调用会立即中断。

-

若长时间未确认,MCP 连接可能会超时断开(不同应用等待时间不同,通常为几分钟)。

-

-

始终允许

-

跳过确认流程,Gety 查询到的片段会直接发送给 AI,使用更顺畅。

-

你可以随时在 设置 → AI 集成 → 数据共享设置 中切换回「始终询问」。

-